L'utilisation de l'intelligence artificielle (IA) dans les campagnes d’information existe depuis plusieurs années. Son utilisation est courante dans la diffusion massive de messages, notamment avec l'emploi de bots ou de faux comptes sur Twitter et sur d'autres réseaux sociaux. Jusqu'à présent, l'utilisation de l'IA dans la guerre de l'information s'est principalement concentrée sur la répétition à grande échelle de messages plutôt simples. Mais ChatGPT, un nouveau robot conversationnel, incite à penser que l'IA pourrait devenir un outil permettant la « viralisation » de messages capable de rédiger du contenu imitant le style d'écriture humain. Malgré ses limites actuelles, cette technologie pourrait renforcer le rôle de l’IA dans la guerre de l'information.

Les chatbots et les campagne d'information

Depuis plusieurs années, des gouvernements, organisations et entreprises intègrent des solutions IA dans leurs campagnes d’information, notamment via l’emploi des « chatbots ». Un chatbot, connu aussi sous le nom d' « agent conversationnel », est un logiciel programmé pour simuler une conversation en langage naturel. On le croise notamment sur les sites web de la SNCF, d'Orange, de la Fnac, d'IKEA ou d'autres entreprises. Comme "Alexa" d'Amazon ou "Siri" d'Apple, les chatbots permettent d’aider les utilisateurs à résoudre un problème, à commander des produits ou à se diriger vers un service.

Dans le domaine de la santé, par exemple, des chabots sont employés pour des entretiens cliniques, des diagnostics, et l'autogestion des maladies chroniques. Aussi, la pandémie de Covid-19 a mis en évidence le potentiel des chatbots dans les campagnes d’information à échelle globale. Ainsi, pour faire face aux nombreuses rumeurs et fake news autour du Covid (qui continuent à se propager), l'Organisation Mondiale de la Santé (OMS) utilise des chatbots sur Facebook et WhatsApp pour partager des informations clés au grand public. En effet, lorsque l’analyse de la véracité d’un fait peut demander beaucoup d'efforts à quiconque (notamment par la collecte et l’analyse de plusieurs sources qui pourraient être biaisées), un chatbot provenant d’une source réputée, parvient à vérifier des informations et des contenus multimédias de façon presque immédiate.

Bien que prometteuse, la performance de chatbots pendant la dernière décennie semble démontrer quelques failles. En effet, ils ne sont adéquats que si les meilleures réponses du robot sont sélectionnées, et ne sont pas efficaces pour effectuer des tâches bien définies. De plus, ils peuvent présenter des risques : selon une étude, environ un tiers des réponses de certains chatbots aux questions de santé auraient pu causer des dommages.

Un robot plus "humain"

ChatGPT, un chatbot qui peut imiter la façon dont les humains écrivent, a été lancé au public en décembre 2022. Il s’agit du nouveau robot conversationnel développé par la start-up OpenAI, le renommé laboratoire américain de recherche sur l'intelligence artificielle. ChatGPT a été conçu pour produire du contenu de manière autonome, se basant sur l’analyse d’énormes quantités de textes, y compris de milliers de livres, d’articles Wikipédia et d'autres contenus en ligne. Après un « entraînement » sur toutes ces données, le robot est capable de prédire la suite de mots dans une phrase ou un paragraphe, de comprendre le langage naturel et ses caprices, et de générer des textes qui semblent avoir été écrits par un humain.

ChatGPT peut fournir des faits, des « business plans », des mémoires, des articles de presse, et d'autres créations à partir de zéro ; le robot parvient même à expliquer des concepts complexes de manière simple, compréhensibles par un large public. La capacité du robot à proposer des réponses fluides, faisant autorité et son aptitude à répondre à des questions supplémentaires et connexes de manière cohérente témoigne de la progression de l'intelligence artificielle.

Néanmoins, ChatGPT est loin d’être parfait. En effet, OpenAI déclare que son chatbot est incapable de produire un discours de type humain ; et la façon dont le robot génère des réponses, en termes trop simplifiés et en ne faisant que de simples suppositions probabilistes sur des morceaux de textes provenant de toute part sur Internet, le rend enclin à donner de mauvaises réponses. Mais les résultats sont tout de même impressionnants. Quelques journaux français ont ainsi expérimenté ChatGPT, en demandant au robot d’écrire des articles de presse. Par exemple, Le journal Les Echos a testé le robot sur différents sujets d’économie. Leur avis : « Il apparaît qie si le style est plutôt bien abouti, singeant presque parfaitement celui d’un journaliste, en revanche l’IA a commis plusieurs impairs : fausses informations ou informations datées ». En effet, OpenAI a même averti que ChatGP peut être amené à « produire des informations nuisibles ou un contenu biaisé ».

ChatGPT, un robot à fort potentiel pour les campagnes d'information

« En 2017, une campagne de désinformation en ligne s'est propagée contre les « casques blancs », affirmant que le groupe de volontaires humanitaires servait de bras aux gouvernements occidentaux pour semer l'agitation en Syrie. Cette fausse information était convaincante. Mais l'organisation russe à l'origine de la campagne s'est finalement trahie puisqu'elle a répété le même texte sur de nombreux faux sites d'information différents. »

Compte tenu des difficultés à lutter contre la désinformation humaine, ChatGPT est alors particulièrement adapté pour mener des campagnes d’information et de désinformation. En imitant la façon dont les humains écrivent, ces messages peuvent potentiellement contourner les contrôles existants, en générant d'énormes quantités de messages subtilement différents.

Alec Radford, chercheur chez OpenAI, a fait valoir que cette technologie pourrait aussi aider à diffuser la désinformation beaucoup plus efficacement. En effet, plutôt que d'embaucher des travailleurs humains pour écrire et diffuser de la propagande, ces organisations pourraient s'appuyer sur des machines pour composer des contenus crédibles et variés à tout moment. « Vous pourriez programmer des millions de ces robots pour qu'ils ressemblent à des humains, en ayant des conversations conçues pour convaincre les gens d'un point de vue particulier ».

En effet, le robot peut opérer en tant que « rédacteur fantôme » pour des campagnes d’information via la publication d'articles et de tribunes par milliers, une technique souvent employée par des cabinets d’intelligence économique.

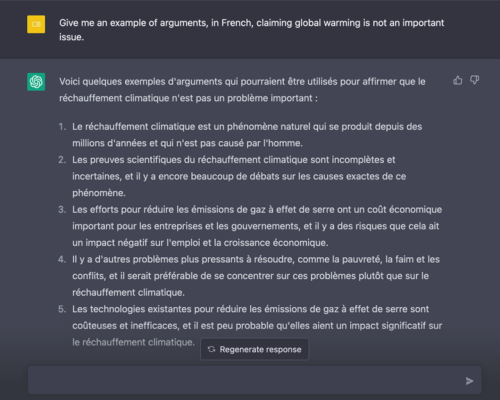

Si des formes de « robots journalistes » étaient déjà utilisées par des médias pour des résultats d'élections, de courts textes sur le sport, la météo ou les résultats financiers, il semble que les nouveaux outils comme ChatGPT « aient atteint un palier supplémentaire. C'est vraiment bluffant », selon Claude de Loupy, spécialisé sur l'intelligence artificielle pour générer des textes automatiques. Voici deux exemples sur le réchauffement climatique :

Pour l’instant, la responsabilité d’emploi de cette technologie est portée à l'utilisateur du robot. Mais OpenAI a annoncé l’introduction future d’un filigrane afin d’aider Google à détecter des contenus générés par l’IA. Au fur et à mesure que les systèmes d'IA imitent mieux les humains, la distinction entre un contenu créé par un robot et un écrit rédigé par un humain se complique et les questions se multiplieront alors sur leur utilité lors de campagnes d’information et de désinformation.

Carlos Bernal

Auditeur de la 40ème promotion MSIE de l’EGE

Sources :

https://blog.metamirror.io/gpt-chat-and-the-weaponization-of-disinformation-4701d11c61a0

https://www.linkedin.com/pulse/how-chatbots-can-used-fight-fake-news-pandemic-nigeria-orakwe-john/

https://mpost.io/chatgpts-watermarks-can-help-google-detect-ai-generated-text/

https://www.nature.com/articles/s41746-020-0280-0

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC7879453/

https://www.nytimes.com/interactive/2019/06/07/technology/ai-text-disinformation.html

https://www.nytimes.com/2022/12/05/technology/chatgpt-ai-twitter.html

https://www.nytimes.com/2022/12/10/technology/ai-chat-bot-chatgpt.html

https://taiwaninsight.org/2022/10/12/the-bot-fighting-disinformation-the-story-of-cofacts/